A ética em inteligência artificial (IA) tornou-se uma questão central à medida que a tecnologia avança e permeia cada aspecto de nossas vidas.

Este texto explora os fundamentos da ética em IA, os desafios que surgem durante sua implementação e as regulamentações necessárias para garantir um futuro em que a tecnologia avance e respeite os valores fundamentais da justiça e da responsabilidade.

Fundamentos da ética em inteligência artificial

Os fundamentos da ética em IA se baseiam em princípios que visam garantir que a tecnologia seja desenvolvida e aplicada de maneira justa e responsável. Entre esses princípios, destaca-se a justiça, que busca evitar preconceitos e discriminações nos algoritmos.

É crucial que os sistemas de IA não perpetuem ou amplifiquem desigualdades existentes, e que sejam projetados para promover equidade entre diferentes grupos sociais.

A transparência é outro pilar essencial; ela exige que as decisões tomadas por algoritmos sejam compreensíveis e rastreáveis, permitindo que os usuários entendam como e por que determinadas conclusões foram alcançadas.

A falta de transparência pode gerar desconfiança e dificultar a identificação de falhas ou viés nos sistemas.

Além da justiça e da transparência, a responsabilidade é fundamental na ética da IA. Isso envolve a obrigação dos desenvolvedores e implementadores de assegurar que suas criações sejam seguras e que qualquer impacto negativo seja mitigado de forma adequada.

A responsabilidade também abrange a necessidade de criar mecanismos para a responsabilização por decisões automatizadas, garantindo que as ações dos sistemas de IA possam ser auditadas e que as partes responsáveis sejam identificáveis.

Esses princípios formam a base para um desenvolvimento ético e responsável da IA, essencial para a construção de um futuro tecnológico que respeite e promova valores humanos fundamentais.

Desafios éticos na implementação da IA

A implementação de IA enfrenta uma série de desafios éticos complexos que podem impactar negativamente a sociedade se não forem abordados adequadamente.

Um dos principais desafios é o viés algorítmico, que ocorre quando os sistemas de IA replicam ou amplificam preconceitos existentes nos dados com os quais foram treinados.

Isso pode levar a decisões discriminatórias em áreas críticas como contratação, justiça criminal e concessão de crédito, prejudicando grupos minoritários e perpetuando desigualdades sociais.

Para mitigar esse problema, é essencial adotar práticas rigorosas de auditoria e validação dos algoritmos e garantir que a diversidade de dados seja considerada no desenvolvimento dos sistemas.

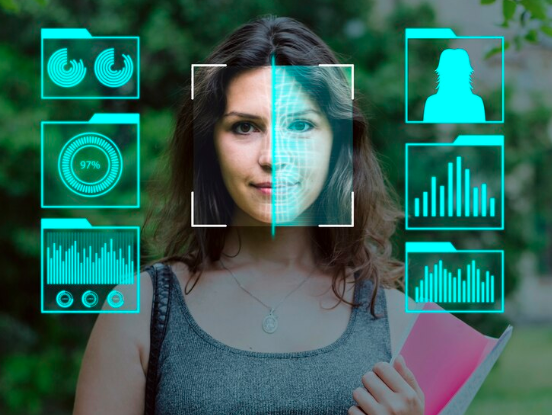

Outro desafio significativo é a privacidade dos dados, uma vez que a IA frequentemente depende de grandes volumes de informações pessoais para operar de maneira eficaz.

O uso inadequado ou a falta de proteção dessas informações podem resultar em violações de privacidade e abusos de dados. Garantir que os dados sejam coletados, armazenados e utilizados de forma ética e segura é crucial para manter a confiança dos usuários e evitar danos.

É necessário implementar regulamentos robustos para proteger os dados pessoais de clientes que buscam aluguel de lixadeira e assegurar que os sistemas de IA respeitem os direitos dos indivíduos, promovendo uma abordagem mais responsável e transparente.

Regulamentação e normas de governança

A regulamentação e as normas de governança são essenciais para assegurar que o desenvolvimento e a aplicação da inteligência artificial sejam realizados de forma ética e responsável.

Vários países e organismos internacionais têm trabalhado na criação de diretrizes e regulamentos para enfrentar os desafios impostos pela IA.

A União Europeia, por exemplo, propôs o Regulamento Geral sobre a IA, que estabelece requisitos para garantir que sistemas de IA sejam seguros, transparentes e não discriminatórios.

Essas regulamentações visam criar um ambiente onde a inovação possa prosperar sem comprometer a proteção dos direitos e a segurança dos cidadãos que contratam uma empresa para aplicar verniz fotoluminescente.

Além das regulamentações específicas, as normas de governança também desempenham um papel crucial. Elas fornecem estruturas e melhores práticas para a gestão ética de IA, como a criação de comitês de ética e auditorias regulares dos sistemas.

A governança eficaz envolve a implementação de princípios que garantam a responsabilidade dos desenvolvedores e a conformidade com as regulamentações vigentes.

A colaboração entre governos, empresas e instituições acadêmicas é fundamental para criar um arcabouço regulatório robusto e adaptável, capaz de acompanhar a rápida evolução da tecnologia e responder a novas questões éticas que surgem.

O papel da transparência e da responsabilidade

A transparência e a responsabilidade são pilares fundamentais para a construção de sistemas de IA que sejam éticos e confiáveis. A transparência implica que os algoritmos e suas decisões sejam compreensíveis e acessíveis para os usuários e partes interessadas.

Isso significa que os desenvolvedores devem documentar claramente como os sistemas de IA funcionam, quais dados são utilizados e como as decisões são tomadas.

A transparência não apenas ajuda a construir confiança com o público de uma fabricante de acetato de vinila, mas também facilita a identificação e correção de erros ou vieses nos sistemas, promovendo uma maior equidade e justiça.

Por outro lado, a responsabilidade refere-se à obrigação dos criadores e implementadores de IA de garantir que suas tecnologias sejam usadas de forma segura e ética. Isso inclui a criação de mecanismos para a responsabilização quando decisões automatizadas causam danos ou injustiças.

Além disso, a responsabilidade envolve a criação de processos para a revisão e auditoria contínua dos sistemas de IA, assegurando que eles cumpram com as normas e regulamentações estabelecidas.

Juntas, a transparência e a responsabilidade ajudam a garantir que a IA seja desenvolvida e implementada de maneira que respeite os valores humanos e promova um futuro tecnológico mais ético e confiável.

Futuro da ética em IA

O futuro da ética em inteligência artificial está em constante evolução, refletindo o avanço rápido da tecnologia e as crescentes preocupações sociais. Uma das principais tendências emergentes é o foco crescente em IA explicável.

À medida que os sistemas de IA se tornam mais complexos, a necessidade de tornar suas operações e decisões mais compreensíveis para os humanos torna-se crucial.

A IA explicável visa melhorar a transparência dos algoritmos e permitir que os usuários entendam e confiem mais nos sistemas automatizados, promovendo uma maior responsabilidade e reduzindo o risco de viés.

Outra perspectiva importante para o futuro da ética em IA é a integração de princípios éticos desde a concepção.

Em vez de tratar as questões éticas como uma etapa posterior no desenvolvimento, há um movimento crescente para incorporar considerações éticas diretamente no design e na arquitetura dos sistemas de IA.

Isso inclui a criação de frameworks de governança adaptáveis e a formação de equipes diversificadas de desenvolvimento para abordar possíveis vieses e garantir que os sistemas respeitem valores éticos universais.

Essas abordagens proativas visam garantir que a IA evolua de maneira a beneficiar a sociedade e empresas de carrinho inox para transporte de alimentos de forma equitativa e responsável.